Herausforderungen bei der Daten-Reconciliation – Eine Beispielanwendung

Sichern Sie die Genauigkeit Ihrer Daten mit maßgeschneiderten Abstimmungslösungen von CID. Erzielen Sie Automatisierung, Qualität und Erkenntnisse für intelligentere Geschäftsentscheidungen.

In der heutigen datengetriebenen Welt kämpfen Organisationen ständig damit, die riesigen Datenmengen, die aus verschiedenen Quellen generiert werden, zu einem konsolidierten Datensatz zusammenzuführen. Diese einheitliche Sichtweise ist entscheidend für fundierte, datenbasierte Geschäftsentscheidungen. Im ersten Teil dieser Serie haben wir einen Überblick über die Bedeutung und Methoden der Reconciliation (auch Data-Reconciliation oder Datenabgleich genannt) gegeben. Heute gehen wir auf einige Herausforderungen ein, die in diesem Prozess auftreten, und wie wir bei CID sie angehen. Wir arbeiten mit einem konkreten Anwendungsfall, um es greifbarer zu machen.

Unser Anwendungsfall ist ein Automobilhersteller, der seine Vielzahl von Lieferanten im Blick behalten muss, um seinen Fertigungsprozess effizient zu planen und auf mögliche Unterbrechungen in der Lieferkette zu reagieren. Dazu benötigt der Automobilhersteller eine akkurate Datenbank, die alle Lieferanten und Informationen darüber enthält, wie diese mit anderen Entitäten wie Organisationen und Einzelpersonen in Beziehung stehen. Wir gehen davon aus, dass der Automobilhersteller bereits seine direkten Lieferanten in einer Datenbank erfasst hat. Es fehlen jedoch noch einige Informationen über diese Lieferanten, und nicht alles über die Lieferanten der Lieferanten ist bekannt. Mit einiger Mühe lässt sich ein vielversprechender Anbieter von Daten, die diese Lücken füllen können, finden. Jedoch reicht das bloße Vorhandensein dieser neuen Daten nicht aus, um ein vollständiges Bild der Lieferkette zu erhalten.

Um die besten Einblicke aus den Daten zu gewinnen, müssen die vorhandenen Daten über die Lieferanten mit den neuen Unternehmensdaten in einem einzigen Datensatz angereichert werden. Da es in der Regel keine Standard-IDs zwischen verschiedenen Datensätzen gibt, braucht man eine andere Lösung, um sie abzugleichen, d.h. einen Algorithmus, der die gemeinsamen (und einzigartigen) Entitäten und Beziehungen aus den bekannten Daten und den neuen automatisch und auf große Datenmengen skalierbar identifiziert. Dieser Artikel wird einige Herausforderungen bei der Entwicklung eines solchen Algorithmus ansprechen und Einblicke in eine Lösung bieten.

Datenqualitätsprobleme

Jede neue Datenquelle, die man erwirbt, bringt nicht nur neues Wissen, sondern potenziell auch Fehler mit sich. Einige dieser Fehler können unmöglich entdeckt werden – schließlich kann man nicht jeden einzelnen Datenpunkt nachprüfen. Andere Arten von Fehlern lassen sich jedoch durch systematisches Überprüfen von Annahmen über erwartete Datentypen und Wertebereiche automatisiert finden.

Beispielsweise erwartet man in einem Feld, welches das Gründungsdatum eines Unternehmens enthält, ein Datumsformat oder einen Wert, der in ein solches Format umgewandelt werden kann. Außerdem sollte dieses Datum nicht in der Zukunft oder zu weit in der Vergangenheit liegen. Ein Feld mit CEO-Informationen sollte auf eine Person oder mehrere Personen verweisen oder deren Namen enthalten. Ein Feld, das das Land darstellt, in dem ein Unternehmen registriert ist, sollte ebenfalls eine ID enthalten oder den Namen eines existierenden Landes, usw.

All diese Erwartungen können in einem Datenschema definiert werden, das auf alle Daten angewendet wird. Lassen Sie uns dieses wichtige Konzept im Detail erkunden.

Inkonsistente Datenschemata

Ein Schema ist ein Plan der Datenarchitektur, der gültige Inhalte wie Entitätstypen, Datentypen oder Schlüssel-Wert-Paare definiert. Jede neue Datenquelle hat ihr eigenes Schema.

Wenn wir die obigen Beispiele noch einmal betrachten, könnten die erwähnten Datumsfelder in verschiedenen Formaten vorliegen, z.B.:

- YYYY/MM/DD

- MM/DD/YYYY

- MM.YYYY

- …

Einige Datenquellen könnten Informationen über den CEO eines Unternehmens haben, während andere keine oder nur vage Informationen wie „verbundene Personen“ enthalten. Ein Land könnte auf unterschiedliche Weise dargestellt werden, z.B. „USA“ vs. „Vereinigte Staaten von Amerika“ vs. „ISO 3166-2:US“ usw.

Um mehrere Datenquellen zu kombinieren, muss ein Schema definiert werden, das die Informationen jeder Datenquelle zusammenführt und die Daten aus den Quellen zu dem Schema transformiert. Wenn man jedoch einen konkreten Anwendungsfall für die Daten hat, z.B. den Aufbau einer Lieferkettendatenbank, macht es Sinn, das Schema unabhängig von einer einzelnen Datenquelle zu definieren. Schließlich bestimmt der Anwendungsfall, welche Teile der Daten nützlich sind und welche ignoriert werden können. Ein weiterer Vorteil davon ist, dass das Schema nicht bei jeder neu hinzugefügten Datenquelle neu definiert werden muss.

Identifizierung von Match-Kandidaten

Eine Hauptaufgabe besteht darin, Kandidaten aus allen Datensätzen zu finden, die zusammengeführt werden könnten, d.h. Entitäten, die dasselbe Unternehmen sein könnten. Im einfachsten Fall kann man diese Kandidaten über gemeinsame externe IDs finden, aber in den meisten Fällen existieren diese nicht in allen Datensätzen, und man muss andere stark identifizierende Merkmale berücksichtigen. Diese Merkmale könnten z.B. der Name oder die Website sein. Es reicht jedoch nicht aus, die Merkmale direkt zu vergleichen, da der Name eines Unternehmens unterschiedlich geschrieben werden kann, z.B. in unterschiedlicher Groß-/Kleinschreibung, mit oder ohne Rechtsformen oder mit zusätzlichen Informationen über das Unternehmen. Zum Beispiel:

- „WISAG GEBAEUDEREINIGUNG NORD GMBH & CO. KG“ vs. „WISAG Gebäudereinigung Nord“

- „RUESS GMBH, WÄSCHEREI, TEXTILREINIGUNG, MIETBERUFSKLEIDUNG W“ vs. „Ruess GmbH“

Basierend auf dem Namen könnten sie auf dasselbe Unternehmen hinweisen und sollten daher zumindest Kandidaten für einen Match werden. Diese Merkmale müssen also transformiert werden, um „identische“ Einträge in verschiedenen Datenquellen zu finden. Das Auffinden möglicher Kandidaten kann durch Natural Language Processing (NLP) Methoden wie n-gram-basierte Ähnlichkeitsbewertungen unterstützt werden.

Reconciliation von Match-Kandidaten

Sobald die Reconciliation-Kandidaten identifiziert wurden, besteht das nächste Problem darin, zu entscheiden, welche Kandidatenpaare ähnlich genug sind, um sie zusammenzuführen. Hierfür müssen diese anhand der vorliegenden Informationen mit einem Score oder Rank versehen werden. Diese Bewertung sollte von der Natur der Merkmale abhängen. Zum Beispiel liefern identische Adressen mehr Beweise für einen potenziellen Match als nur identische Länderinformationen. Zusätzlich sollte auch die Qualität des Abgleichs eine Rolle spielen. Beispielsweise liefert ein komplexer Unternehmensname mit einer Rechtsform (z.B. „Kayer Automotive Systems L.P.“) mehr Hinweise als ein Name, der nur aus einem Akronym besteht (z.B. „KAS“). Außerdem müssen widersprüchliche und fehlende Informationen unterschiedlich behandelt werden.

Schließlich werden die am besten bewerteten Kandidatenpaare und/oder jene, die über einer bestimmten Score-Schwelle liegen, zu einer Entität gemergt. Durch die Anpassung dieser Schwelle und der Merkmalsgewichte kann das Verhältnis von Präzision und Sensitivität an die jeweiligen Anforderungen angepasst werden. Die Reconciliation von Entitäten kann zu weiteren Kandidaten und Hinweisen auf noch mehr Übereinstimmungen führen, da die Kombination der Informationen über eine Entität aus zwei Quellen größer sein kann als die Informationen aus nur einer Quelle. Dies kann genutzt werden, indem man einen iterativen Ansatz für die weitere Reconciliation anwendet.

Sowohl manuelle Feature-Engineering-Ansätze als auch maschinelle Lernverfahren können zu einem Matching-Algorithmus führen, der gute Ergebnisse liefert und gleichzeitig den manuellen Aufwand erheblich reduziert. Die meisten (oder sogar alle) Matching-Entscheidungen können somit automatisch getroffen werden, während nur einige eventuelle Randfälle menschliches Eingreifen erfordern könnten. Erkenntnisse aus diesen manuellen Korrekturen können wiederum genutzt werden, um den Algorithmus zu verbessern, indem die Merkmale des Modells angepasst oder das Modell mit bereinigten Daten trainiert wird. Dadurch wird der Grad der Automatisierung immer weiter erhöht.

Skalierbarkeit und Komplexität

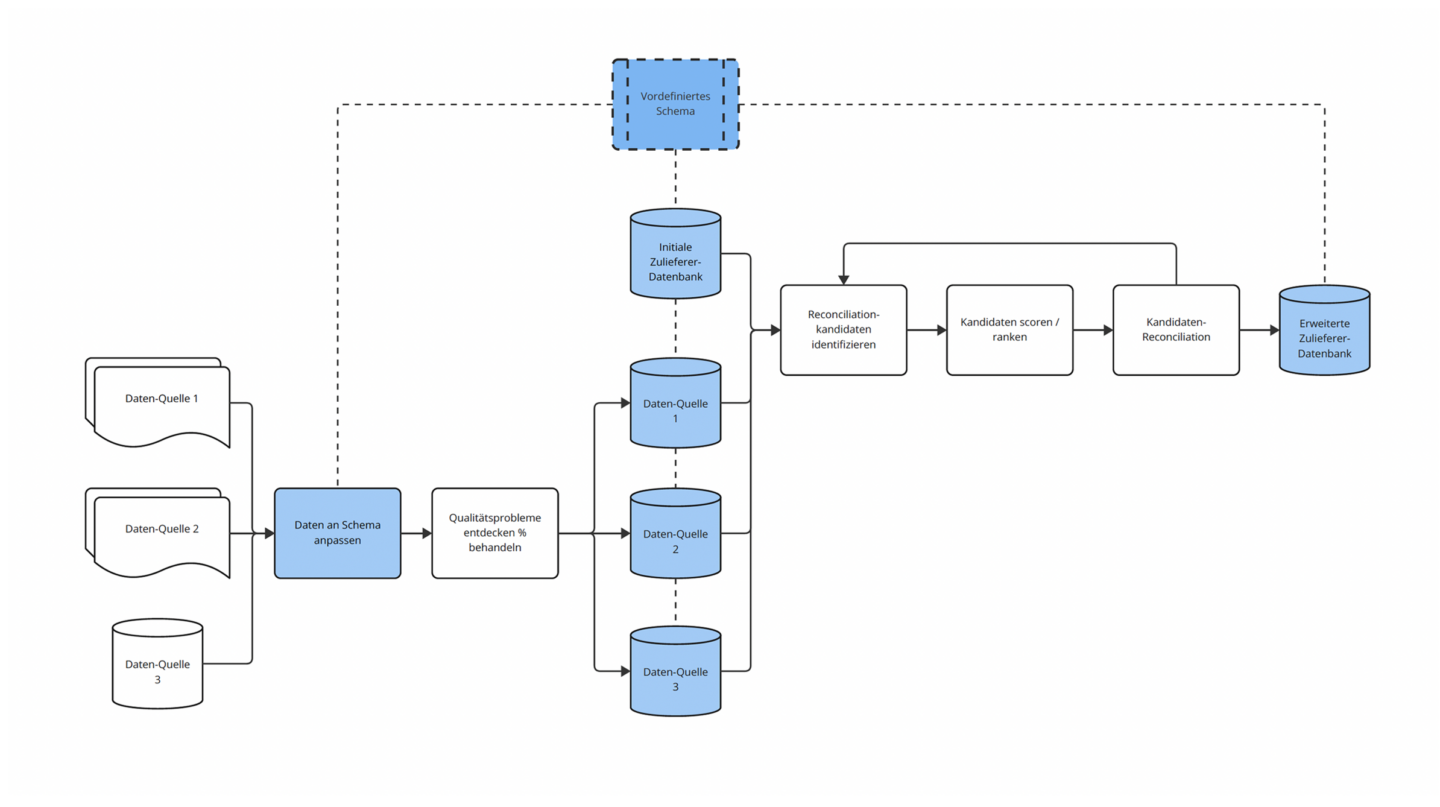

Reconciliation-Entscheidungen können sehr komplex werden und potenziell Tausende von möglichen Match-Kandidaten umfassen. Daher ist es wichtig, die Komplexität, wo immer möglich, zu reduzieren und eine Reconciliation-Pipeline (siehe Abbildung) zu entwickeln, die leicht auf viele Datenquellen und große Datenmengen skalierbar ist.

Die Arbeit mit einem vordefinierten Schema hilft, die Komplexität des Reconciliation-Problems zu verringern, da bei neu hinzugefügten Datenquellen keine wesentlichen Anpassungen vorgenommen werden müssen. Stattdessen müssen nur die neuen Daten an das Schema angepasst werden. Danach sind die Schritte zur Reconciliation der Daten immer gleich. Somit wird der menschliche Aufwand bei dem Hinzufügen neuer Datenquellen überschaubar. Dies skaliert auch besser auf große Datenmengen als der Versuch, alle Aspekte jeder Quelle abzugleichen.

Ein weiteres Problem, das auftritt, wenn man mehr als zwei Datenquellen kombiniert, besteht darin, dass die Komplexität steigt, wenn man alle Matching-Kandidaten aus allen Quellen gleichzeitig berücksichtigt. Ein guter Reconciliation-Algorithmus kann dies bewältigen. Konzeptionell kann man leicht von zwei auf beliebig viele Datensätze skalieren und unerwünschte Effekte vermeiden, die durch die Reconciliation mehrerer Datenquellen mit einem iterativen Ansatz entstehen könnten. Mit anderen Worten: Wenn man zuerst A und B kombiniert und dann C hinzufügt, könnten andere Ergebnisse entstehen als bei der Kombination von B und C mit anschließendem Hinzufügen von A. Daher muss eine Lösung in der Lage sein, A, B und C gleichzeitig zu kombinieren.

Fazit

Reconciliation ist ein entscheidender Schritt, um die Konsistenz und Genauigkeit der Daten sicherzustellen. Das Ziel ist es, eine einzige Quelle der Wahrheit zu definieren, die dabei hilft, Einblicke zu gewinnen, um wertvolle Geschäftsentscheidungen zu treffen. CID kann Ihnen helfen, einen maßgeschneiderten Reconciliation-Prozess zu implementieren, der auf Ihre geschäftlichen Anforderungen, Ihre verfügbaren Daten und Ressourcen zugeschnitten ist. Unser Ziel ist es, einen hohen Grad an Automatisierung zu erreichen und gleichzeitig eine hohe Datenqualität sicherzustellen. Wir verfügen über jahrelange Erfahrung sowohl bei den großen Fragen wie der Organisation von Datenpipelines als auch bei den Details, wie der Definition des besten Schemas für einen Anwendungsfall und der optimalen Gewichtung der verschiedenen Reconciliation-Merkmale.

Autorin © 2024: Lilli Kaufhold – www.linkedin.com/in/lilli-kaufhold-467659110/

Weiterführende Artikel

Reconciliation – So bringen Sie Ordnung ins Datenchaos

Schöpfen Sie das Potenzial Ihrer Daten aus. Erfahren Sie, wie Sie Silos aufbrechen, Datensätze harmonisieren und fundierte Entscheidungen treffen können.

Von Mapping zu Blending – Klärung der Terminologie der Datenintegration

Entdecken Sie zentrale Prozesse der Datenintegration wie Bereinigung und Mapping zur Verbesserung der Datenqualität für fundierte Entscheidungen.

Wissensgraphen: Die Macht der Verbindungen

Entdecken Sie die Vorteile von Wissensgraphen für datengetriebene Anwendungen: Flexible, skalierbare Lösungen für Unternehmen in komplexen…