In der dynamischen Landschaft der modernen Technologien haben nur wenige Innovationen so viel Potenzial zur Umgestaltung verschiedener Branchen gezeigt wie das maschinelle Lernen (ML). Von der Fertigungsbranche über das Gesundheitswesen und den Einzelhandel bis hin zum Finanzwesen setzen viele Unternehmen ML ein, um die Effizienz zu steigern, mühsame Aufgaben zu automatisieren und bahnbrechende Entdeckungen zu machen. Bis heute schaffen es jedoch viele ML-Modelle nicht in die Produktion, wodurch viele Chancen ungenutzt bleiben. Genau hier setzt das Konzept von MLOps an, die Lücke zwischen Prototyp und Produktion zu schließen.

MLOps, kurz für Machine Learning Operations, ist ein Paradigma, das darauf abzielt, den gesamten Lebenszyklus des maschinellen Lernens zu rationalisieren und zu optimieren. Im Kern geht es bei MLOps darum, dass Teams zusammenarbeiten, um ihre Pipelines für maschinelles Lernen zu erstellen, zu testen, zu automatisieren und zu überwachen.

In diesem Artikel lernen Sie die Herausforderungen von ML-Projekten kennen und erfahren, wie MLOps-Prinzipien zur Lösung dieser Herausforderungen beitragen können. Außerdem haben wir einen Überblick über die wichtigsten MLOps-Tools und deren Funktionen zusammengestellt, der Ihnen dabei helfen soll, einen Aufbau zu finden, der Ihren Anforderungen voll entspricht.

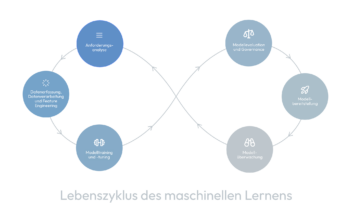

Der Lebenszyklus des maschinellen Lernens

ML-Projekte bestehen in der Regel aus mehreren Phasen. An ihnen können verschiedene Personen oder Teams beteiligt sein, z. B. Data Engineers, Data Scientists, Software Engineers oder DevOps Engineers. Die Projektphasen sind nicht streng linear, sondern können Iterationen oder Wiederholungen erfordern, z. B. aufgrund sich ändernder Eingabedaten oder Projektanforderungen.

Schauen wir uns die Phasen genauer an:

- Anforderungsanalyse: Definieren von Zielen, Umfang und Erfolgskriterien des Projekts sowie etwaiger Beschränkungen.

- Datenerfassung, Datenverarbeitung und Feature Engineering: Sammeln relevanter Datenquellen, Vorverarbeitung der Daten, um fehlende Werte und Ausreißer zu behandeln, und Entwicklung von Features, um die Daten für das Training von ML-Modellen nutzbar zu machen.

- Modelltraining und -tuning: Auswahl geeigneter ML-Algorithmen und Training der Modelle anhand der vorbereiteten Daten.

- Modellevaluation und Governance: Bewertung der Qualität der trainierten Modelle mithilfe verschiedener Bewertungsmetriken und Validierungstechniken. Sicherstellung von Vorurteilsfreiheit, Transparenz und Einhaltung von Richtlinien.

- Modellbereitstellung: Einsatz der Modelle in Produktionsumgebungen, in denen sie Vorhersagen erstellen oder Entscheidungen treffen.

- Modellüberwachung: Kontinuierliche Überwachung der eingesetzten Modelle zur Erkennung von Leistungseinbußen, Datenabweichungen oder anderen Anomalien.

Jede dieser Phasen ist mit besonderen Herausforderungen verbunden. Schauen wir uns das genauer an.

Vorteile von MLOps-Prinzipien und -Tools

MLOps-Prinzipien und -Tools können in jeder der oben genannten Phasen unterstützen, um sie effizienter und besser skalierbar zu machen sowie Risiken zu reduzieren. Letztendlich tragen sie dazu bei, den Geschäftswert und Wettbewerbsvorteil zu steigern. Mit MLOps kann man zum Beispiel Folgendes erleichtern:

- Versionierung von Daten und Code: Versionskontrolle ist entscheidend für die Gewährleistung der Reproduzierbarkeit und Rückverfolgbarkeit in Projekten des maschinellen Lernens. Durch die Versionierung von Daten und Code und die Sicherstellung identischer Laufzeitumgebungen können Unternehmen Änderungen im Laufe der Zeit nachverfolgen, bei Bedarf auf frühere Versionen zurückgreifen und die Zusammenarbeit zwischen Teams effektiver gestalten.

- Dokumentation von Experimenten: Da die Entwicklung von ML-Projekten die Durchführung mehrerer Experimente mit unterschiedlichen Modellen, Parametern oder Trainingsdaten erfordert, kann man leicht den Überblick verlieren. Plattformen zur Nachverfolgung von Experimenten speichern alle notwendigen Metriken und Metadaten, um das Modell-Tuning und die Fehlerbehebung zu erleichtern.

- Hyperparameter-Optimierung: Die meisten ML-Modelle haben verschiedene Hyperparameter, z. B. die Lernrate eines neuronalen Netzes oder die Anzahl der Verzweigungen eines Entscheidungsbaums. Hyperparameter-Tuning-Tools helfen dabei, optimale Werte für diese Hyperparameter zu ermitteln.

- Model Registry: Ein ML-Modell kann während seines Lebenszyklus von der Entwicklung über das Staging und die Produktion bis hin zur Archivierung verschiedene Stadien durchlaufen. Model Registries erleichtern diesen Prozess durch Modellversionierung, Tags oder Aliase.

- Modell-Bereitstellung: Wenn ein ML-Modell nicht in der Produktion eingesetzt wird, ist es für ein Unternehmen letztendlich wertlos. Durch die Automatisierung von Aufgaben wie Code-Integration, Testen und Bereitstellung ermöglichen CI/CD-Tools Unternehmen schnelle Iterationen und eine zuverlässige Bereitstellung von Änderungen.

- Modell-Überwachung: Die Leistung von ML-Modellen verschlechtert sich häufig nach der Bereitstellung aufgrund von Änderungen der Eingabedaten. Modellüberwachungs-Tools helfen dabei, Verschiebungen und Anomalien zu erkennen und automatisch Alerts zu versenden.

- Automatisches Modell-Neutraining: Wenn während der Modellüberwachungsphase eine Datenabweichung festgestellt wird, muss das Modell neu trainiert werden. Tools für das automatische Neutrainieren von Modellen vereinfachen diesen Prozess.

MLOps-Tools

Unternehmen können zwischen einer Vielzahl von Optionen zur Unterstützung ihrer MLOps-Initiativen auswählen: Open-Source-Plattformen wie MLFlow und Kubeflow stehen kommerziellen Lösungen wie Weights & Biases und Amazon SageMaker gegenüber. Hier finden Sie einen Überblick über einige der Plattformen und ihre Funktionen:

[table id=4 /]

Fazit

Die Durchführung eines erfolgreichen ML-Projekts ist nicht einfach. Projekte haben in der Regel einen iterativen Charakter und involvieren Fachleute mit unterschiedlichen Rollen. Es gibt nicht die eine Lösung für jedes Projekt oder Unternehmen. Angefangen bei der Entwicklung von Prototypen für maschinelles Lernen bis hin zu ihrer nahtlosen Integration in die Produktion ermöglicht MLOps Effizienz, Reproduzierbarkeit, Skalierbarkeit und Innovation in Ihren Projekten.

Es gibt eine Fülle von Tools, die Ihnen bei der Lösung Ihrer individuellen Probleme helfen können, und die richtige Auswahl der Tools kann den entscheidenden Unterschied in Ihrem Projekt ausmachen.

Bleiben Sie gespannt auf weitere Beiträge, die sich mit unserer Toolauswahl befassen. Außerdem werden wir demnächst ein LLM-Beispielprojekt vorstellen, das vollständig auf MLOps setzt.

Autoren © 2024:

- Ruth Schreiber – www.linkedin.com/in/ruth-schreiber-0565742ba/

- Dr. Jörg Dallmeyer – www.linkedin.com/in/jörg-dallmeyer-5b3452243/